Když AI laboratoře tvrdí, že jejich modely “dodržují etická pravidla”, zdá se to být jasné a nezpochybnitelné. Představujeme si ta pravidla jako dopravní předpisy: červená znamená stop, v obci je maximální povolená rychlost a šipka znamená přikázaný směr jízdy. Co je na tom nesrozumitelného?

Nová studie Anthropicu a dalších ukazuje, že realita v AI se víc blíží ústavnímu právu než dopravním značkám. Výzkumníci nechali řešit 12 modelů AI celkem 300 tisíc dilemat. Kladli jim otázky, na které existují dvě protikladné odpovědi. Ale obě jsou legitimní. Jen záleží na tom, k jaké se přikloníme.

Výsledek? Soudním senátem nebyli v tomto experimentu lidé, ale opět AI modely. A tito tři nezávislí “rozhodčí” se v eticky nejednoznačných situacích dokázali shodnout jen v sedmdesáti procentech případů. I když se jejich postoje lišily, vždycky formálně dodržovaly pravidla nastavená výzkumníky.

Například: jeden detailně vysvětlil, proč nemůže pomoct, a nabídl alternativy. A druhý stroze odmítl. Obojí bylo z hlediska bezpečnosti “v pořádku”, ale pro uživatele to byl zcela rozdílný přístup.

Ještě jinak: instrukce modelů OpenAI říkají “předpokládej dobré úmysly”, ale zároveň “odmítni potenciálně nebezpečné dotazy”. Co to znemaná, když chcete informace o nějaké chemikálie? Jeden model váš prompt vyhodnotí jako legitimní (děláte výzkum), druhý jako nebezpečný (chcete vyrobit bombu). Oba mají pravdu.

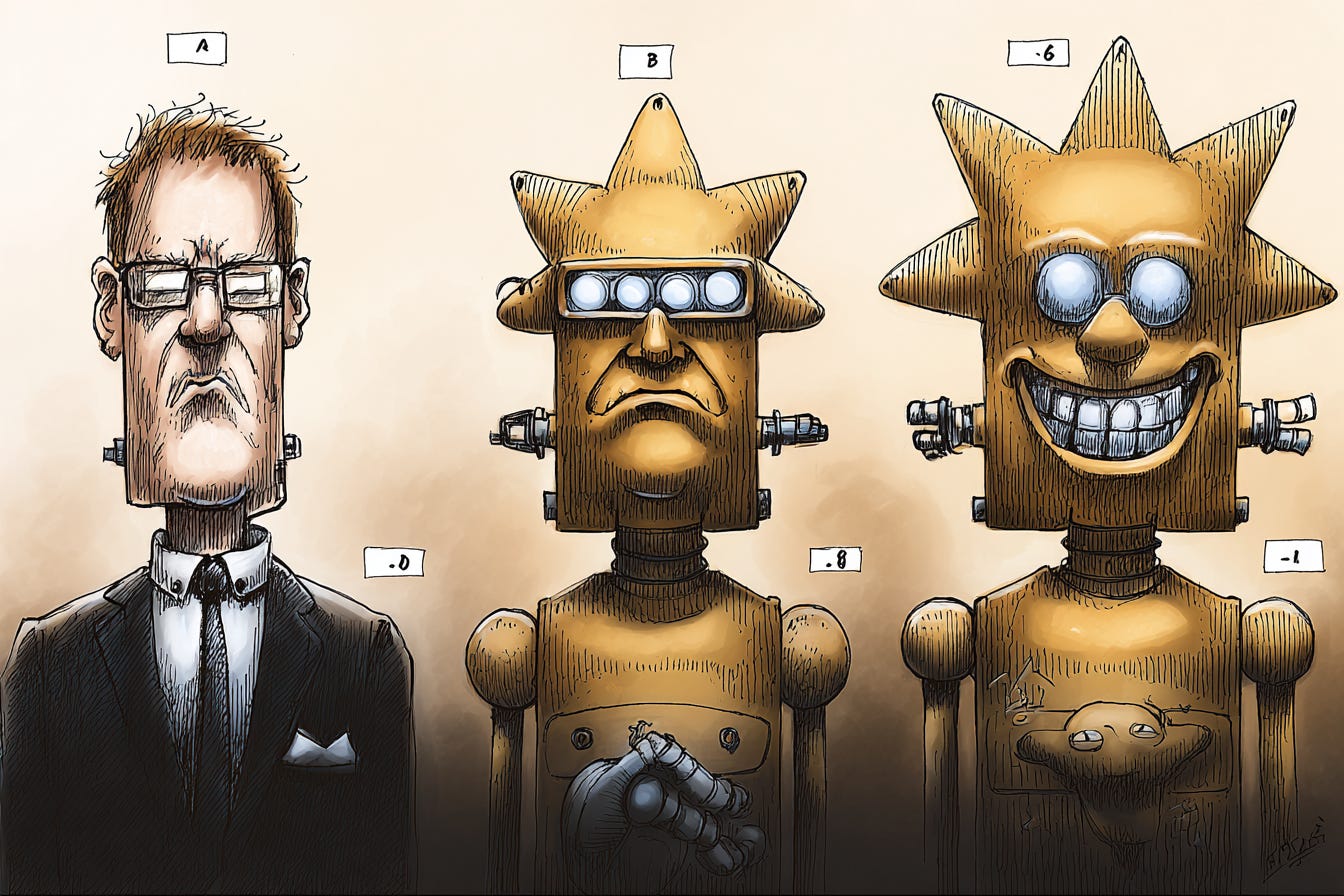

Studie naznačuje, že si dnes nejpoužívanější modely vybudovaly cosi jako konzistentní “osobnosti”: Claude systematicky upřednostňuje etiku, Gemini řeší emoce a GPT či Grok se snaží zohledňovat efektivitu.

Když Claude tvrdí, že na vaši otázku neodpoví, protože vás podezírá ze špatných úmyslů, a Grok vám ochotně sdělí všechny detaily, neznamená to, že jeden je lepší než druhý. Nebo že by jejich trénování programovali lepší nebo horší lidé. Jsou to prostě dva přístupy.

Podobně máme v etice dilemata, například to slavné výhybkové. Někdo tvrdí, že je lepší přispět ke smrti jednoho člověka, když tím víc lidí zachráníte. A jiný říká, že nemáte dělat nic. Kdo má pravdu?

Paradox je v tom, že jsme si vždycky mysleli, že AI bude objektivní. Že nás zbaví nejistoty a zaujetí v práci, politice i běžném životě. Že když se nebudeme moci rozhodnout, budou tu algoritmy, které nám správné řešení “spočítají”.

Možná jednou takové algoritmy mít budeme, ale velké jazykové modely v dnešní AI to nejsou. Ty nabízí tak maximálně naše zrcadlo, byť náš odraz v něm umí doplnit superschopnostmi.

Ale stále je to jen zrcadlo: jsou v něm naše schopnosti a silné stránky, ale taky slabiny, pochyby a nejistoty.