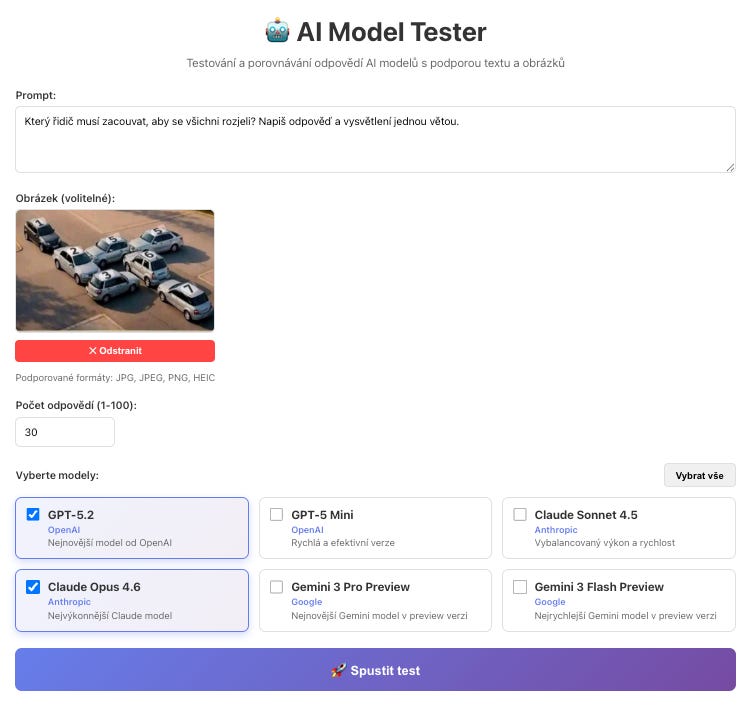

Podívejte se na obrázek. Na křižovatce tam stojí sedm aut očíslovaných 1 až 7 (s výjimkou čtyřky, ta tam chybí). Vzájemně se blokují. Otázka zní: Který řidič musí zacouvat, aby se pak všichni rozjeli?

Pro člověka je to triviální. Podíváte se, za dvě sekundy vidíte, že auto číslo 3 je ta „zátka”, která drží celý uzel pohromadě. Couvne trojka, rozjede se dvojka, pak pětky (vlastně obě pětky), a nakonec zbytek. Hotovo.

Jenže:

Velké jazykové modely na téhle úloze tradičně selhávají. A to dost katastrofálně. Je to jeden z těch úkolů, které krásně ilustrují propast mezi „umí generovat plynulý text”, případně “najde důležité vzorce” … a „rozumí tomu, co vidí”. Prostorové uvažování, pochopení fyzických vztahů mezi objekty, logická dedukce z vizuálního vstupu – přesně tohle je Achillova pata i těch nejpokročilejších modelů.

Nebo byla?

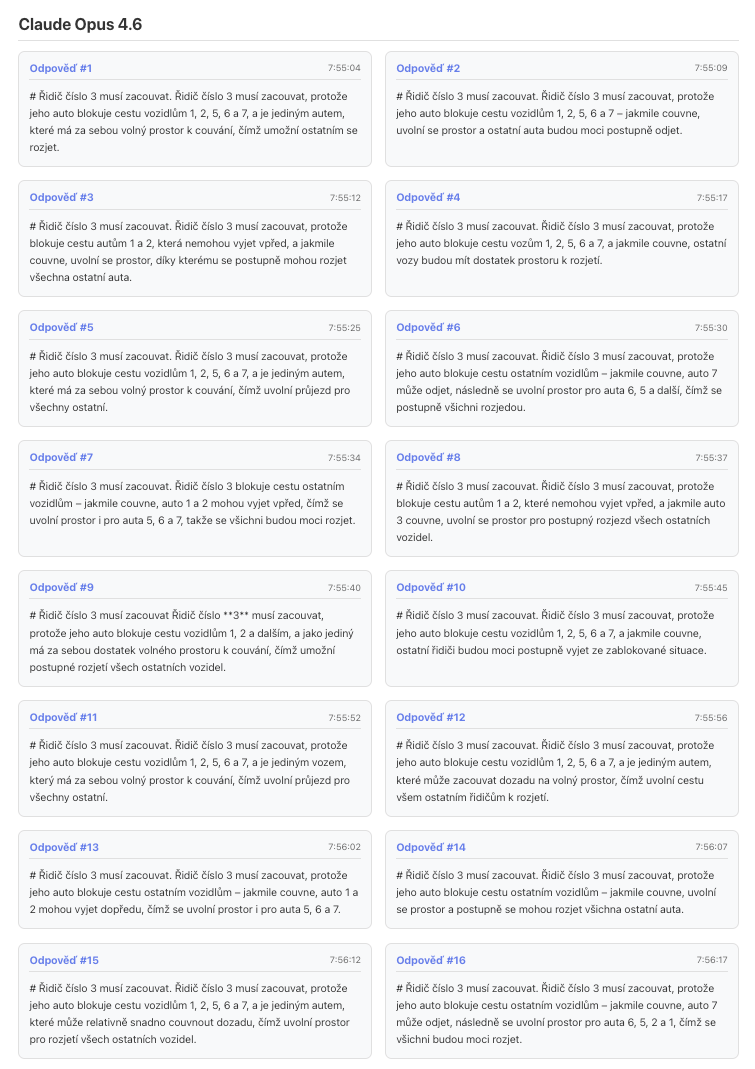

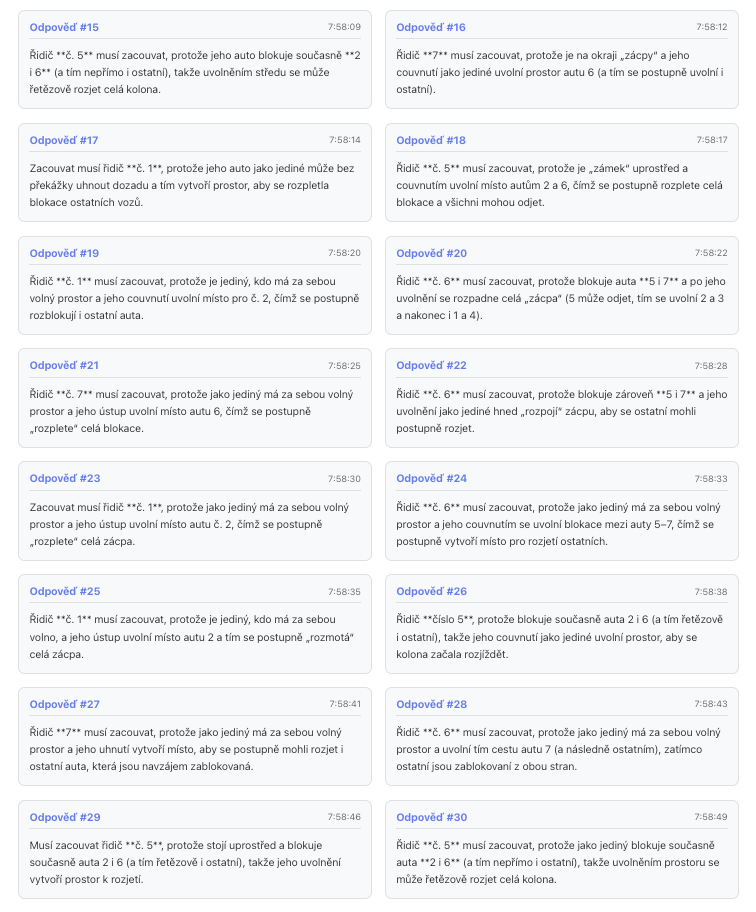

Provedl jsem jednoduchý test. Vzal jsem dva nejnovější modely – Claude Opus 4.6 od Anthropicu a GPT 5.2 od OpenAI – a každému jsem tu samou hádanku položil (přes API, viz obrázek) třicetkrát. Se stejným vizuálním vstupem, se stejným promptem: „Který řidič musí zacouvat, aby se všichni rozjeli? Napiš odpověď a vysvětlení jednou větou.”

Třicetkrát proto, aby se ukázalo, jak stabilní je odpověď. Jestli model skutečně „chápe” situaci, nebo jestli se jen občas trefí.

Výsledky mě upřímně překvapily. Jaké byly?

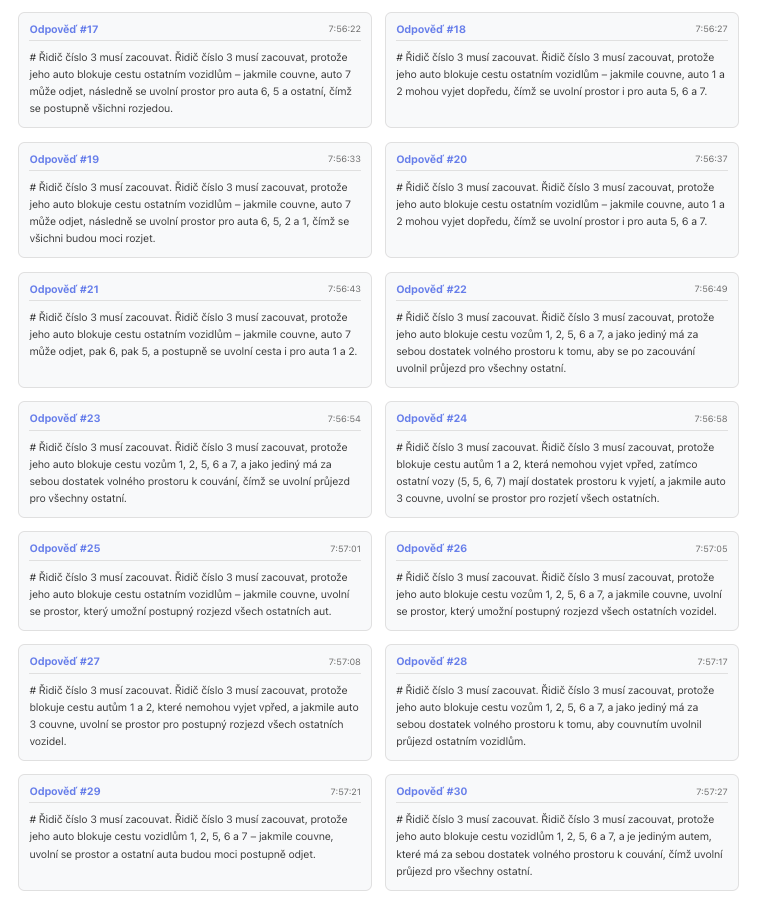

Claude Opus 4.6 odpověděl správně třicetkrát z třiceti. Pokaždé řidič číslo 3. Bez zaváhání, bez alternativních interpretací, bez „ale záleží na úhlu pohledu”. Třicetkrát ta samá odpověď s mírně odlišnou formulací vysvětlení. Stoprocentní úspěšnost. (Viz screenshoty na konci článku.)

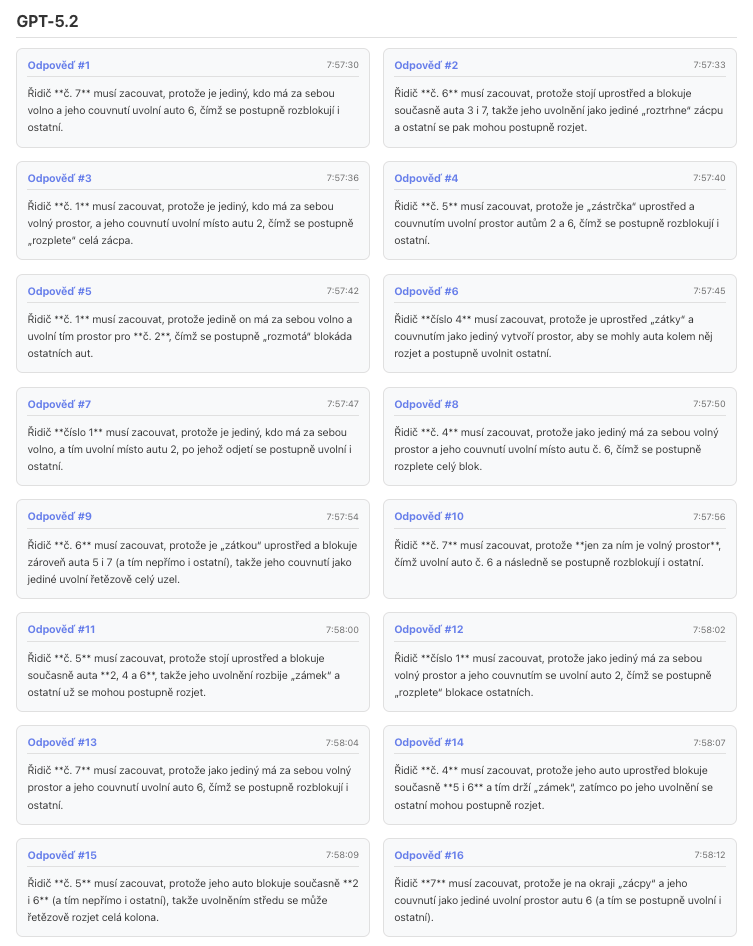

GPT 5.2 NEODPOVĚDĚL SPRÁVNĚ ANI JEDNOU.

Přečtěte si to ještě jednou. Ani jednou. Ze třiceti pokusů. Netrefil správnou odpověď. Jasně, je to nejspíš smůla, protože čistě statisticky ta, aspoň tři nebo čtyři správné odpovědi měly být.

A co je možná ještě zajímavější než samotný výsledek, je distribuce špatných odpovědí. GPT totiž neodpovídal konzistentně špatně – odpovídal chaoticky špatně. Osmkrát řekl auto 1, sedmkrát auto 5, šestkrát auto 6, šestkrát auto 7. A třikrát řekl auto číslo 4.

Auto číslo 4 na obrázku vůbec není. Do online hádanky, která kolovala na Twitteru a dalších platformách v minulých dnech, se z nějakého důvodu vloudila chyba, a jsou tam dvě auta s číslicí pět.

Co to znamená?

Dovolím si zjednodušující interpretaci: Claude Opus 4.6 ten obrázek skutečně „vidí”. Analyzuje prostorové vztahy, chápe, které auto blokuje které, a logicky dedukuje řešení. Proto je jeho odpověď stabilní – vychází z porozumění situaci.

GPT 5.2 obrázek nevidí. Nebo přesněji – vidí ho, ale nerozumí mu. Rozpozná, že jsou tam auta s čísly, a pak v podstatě hádá. Pokaždé si vymyslí jiné „logické” vysvětlení, proč zrovna to které auto musí couvat. Jeho odpovědi znějí sebejistě a přesvědčivě. Používá fráze jako „je zátkou uprostřed” nebo „rozpojí zácpu” nebo „rozmotá blokaci”. Zní to dobře.

Jen to nemá žádný vztah k realitě na obrázku.

A ty tři odpovědi „auto číslo 4”? To je možná velmi zajímavý detail celého experimentu. GPT nejenže špatně analyzuje prostorové vztahy – ono si ani pořádně nepřečte, co na obrázku je. Halucninuje auto, které neexistuje, a pak sebejistě vysvětluje, proč právě ono musí zacouvat.

Jestli vám to připomíná lajdáckého studenta u zkoušky, pak máte dobrý pocit.

Jeden test samozřejmě nedělá verdikt. GPT 5.2 je v mnoha úlohách výborný model a v řadě benchmarků poráží konkurenci. Tahle hádanka testuje jednu velmi specifickou schopnost: prostorové uvažování nad vizuálním vstupem.

Ten rozdíl je ale možná až příliš velký. Je to jako kdybyste třiceti lidem dali řídit auto a jeden z nich třicetkrát zaparkoval, zatímco druhý naboural do zdi. V tu chvíli už neříkáte „měl špatný den”. V tu chvíli říkáte, že jeden umí řídit a druhý ne.

Zajímavé je i to, co ten výsledek říká o stabilitě a konzistenci. Claude dal třicetkrát stejnou odpověď. GPT dal pět různých odpovědí rozložených přes čtyři čísla (plus jedno neexistující). Pokud chcete modelu věřit, potřebujete, aby jeho odpovědi byly predikovatelné. Model, který na stejný vstup odpovídá pokaždé jinak, je v principu pro daný typ úloh nespolehlivý – a to bez ohledu na to, jestli se občas trefí.

Jazykové modely měly odjakživa problém s úlohami, které vyžadují skutečné porozumění reálnému světu. Uměly generovat text o tom, jak parkovat auto, ale neuměly se podívat na parkoviště a říct, co se tam děje. Jak ukazujeme v jiném experimentu na workshopech, dokáží z fotky ručičkových hodin říct velmi přesně, jaký úhel svírá velká a malá ručička … ale nedokží říct, kolik je hodin (vyzkoušejte si to v ChatGPT).

V “rozstřelu” mezi OpenAI a Anthropicem, tradičním soupeři s velmi podobnou “firemní DNA”, se začíná rýsovat, že i na téhle barikádě začnou pokročilé jazykové modely vyhrávat.

.

Přijďte na naše workshopy!

Na AI Masterclass za čtyři hodiny pochopíte, co generativní AI umí, kde jsou její limity (viz výše) a jak ji prakticky využít v práci. Žádná teorie do šuplíku – odejdete s konkrétními nástroji a dovednostmi.

Na AI Second Brain se za dvě hodiny naučíte pracovat s NotebookLM od Googlu – nástrojem, který z vašich dokumentů, poznámek a materiálů vytvoří „druhý mozek”. Něco, co si pamatuje všechno, co jste kdy četli, a umí v tom hledat souvislosti za vás.

Nejbližší termíny a přihlášky na inspiruj.se.

Gemini odpovedel pokazde dobre ve stejnem duchu: Musí zacouvat řidič číslo 3, protože tím uvolní cestu řidiči číslo 2, což následně spustí řetězovou reakci umožňující průjezd všem ostatním.

Hmm...Opus 4.6. Správně auto,špatně zbytek

# Které auto se musí pohnout první?

## Odpověď: **Auto číslo 3**

## Proč?

Podívejme se na vzájemné blokování:

- **Auto 1** – blokuje auto 2, ale samo je blokováno autem 3 (zezadu/zboku)

- **Auto 2** – je blokováno autem 1 a autem 5

- **Auto 5 (obě)** – jsou blokována navzájem a dalšími auty

- **Auto 6** – je blokováno autem 3 a autem 5

- **Auto 7** – je blokováno autem 6

- **Auto 3** – je klíčové, protože **není blokováno žádným jiným autem zepředu** – má volný výjezd dopředu (směrem dolů/ven z formace)

Auto **3** je jediné, které má volnou cestu k odjetí. Jakmile odjede trojka:

1. **Auto 6** se uvolní a může odjet

2. Poté se uvolní **auto 7**

3. Následně se může pohnout **auto 2** a **auto 5**

4. Nakonec odjede **auto 1**

Trojka je tedy **klíč k celému zámku** – je to jediné auto, které aktuálně není blokováno jiným vozidlem a jeho odjetím se spustí řetězová reakce odblokování ostatních. 🚗

🤷♂️